«В плохих руках эта технология может стать оружием». Почему сейчас так много говорят о дипфейках

Новости Беларуси. Эта тема может коснуться любого из нас, сообщили в программе «Неделя» на СТВ.

Юлия Огнева, СТВ:

Хорошо помню свое замешательство, когда чуть было не приняла Джима Кэрри за величайшего актера современности. Одно время в сети активно набирало обороты популярности видео, в котором он якобы точь-в-точь копирует Джека Николсона в одной из сцен легендарного фильма Стэнли Кубрика «Сияние». Помните, обезумевший писатель прорубает топором дверь, просовывает голову внутрь и, скалясь, кричит: «А вот и Джонни»?

По итогу Джим Кэрри, конечно, неплох, но точно не настолько. Оказалось, это технология подмены лиц в видео. Искусственный интеллект deepfake. И все бы ничего, если бы технология не становилась все более совершенной, а в сети не стали появляться ролики с политиками.

И тут вопрос: где грань между безобидной шалостью и вседозволенностью? И как не попасть на уловку информационных мошенников?

Выяснил Дмитрий Боярович.

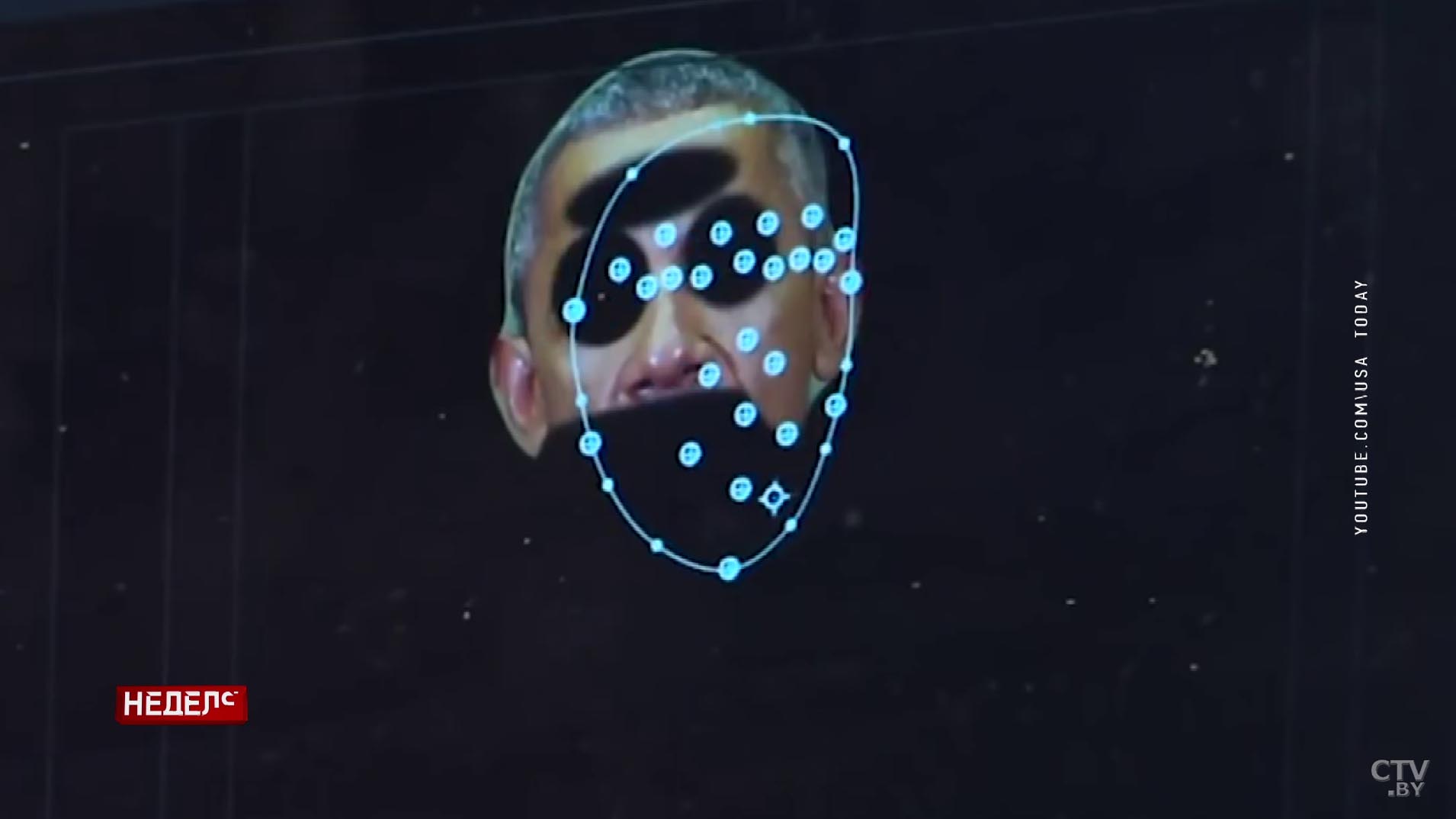

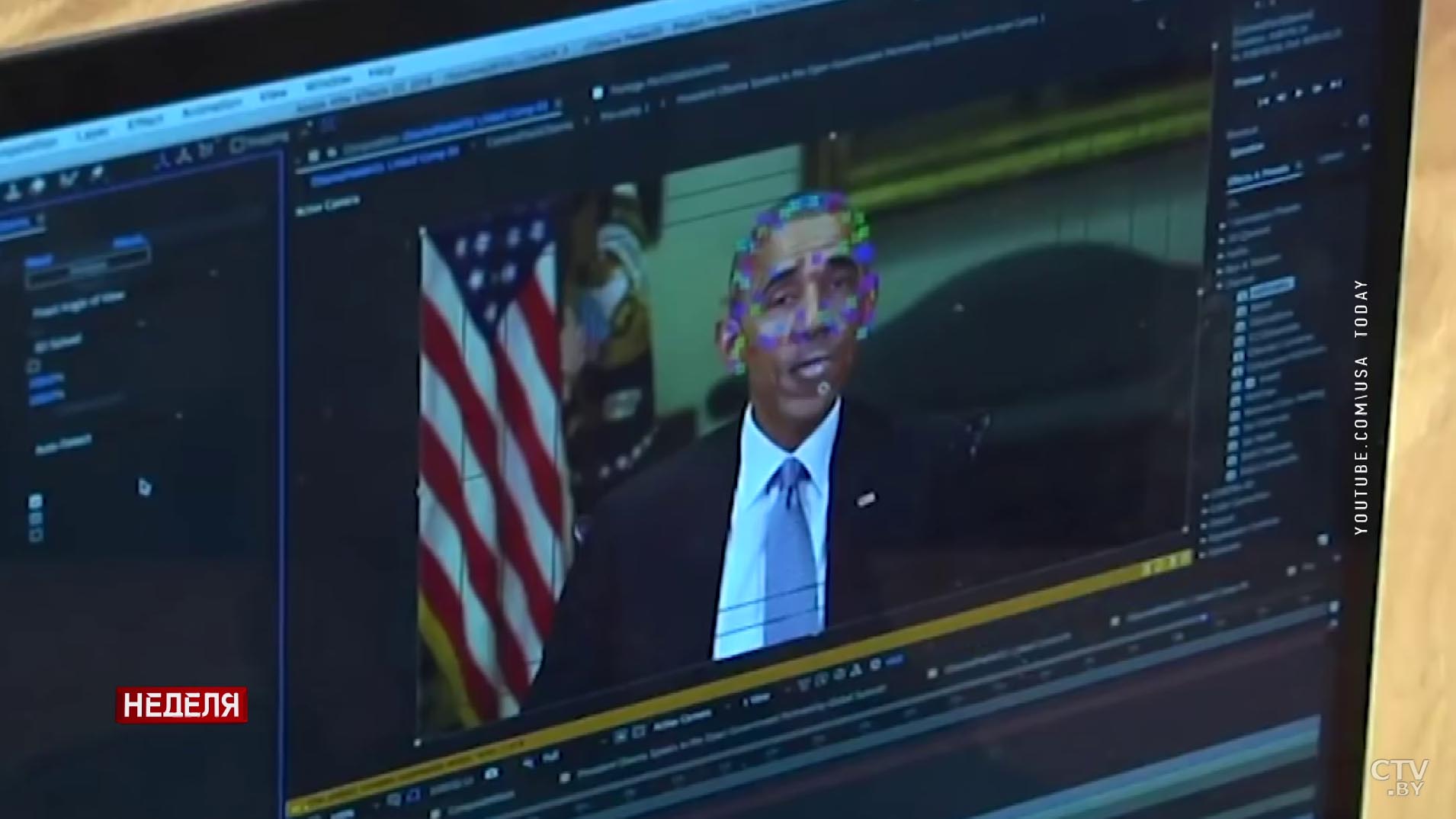

Характерная внешность, жесты и мимика. Едва ли зритель поспорит с тем, что на экране Барак Обама, экс-президент США. А мы все-таки зададим вопрос: «Вы уверены?»

Пользователи интернета до сих не могут поверить в то, что это видео – фейк. В роли политика в нем Джордан Пил, американский комик. Ролик моментально стал вирусным. Его просмотрели больше 7 миллионов человек.

Ольга Агейко, кандидат психологических наук, доцент:

То, что мы видим – вот эта фальсификация, эти дипфейки – они вызывают в первую очередь эмоциональный всплеск. Мы видим, нам это как ни странно или нравится, или не нравится, но мы к этому неравнодушны. И мы этим даже делимся в социальных сетях.

Технологию, которая позволяет заменить лицо человека, называют дипфейк («глубокая подмена»). Ее разработали 6 лет назад для киноиндустрии. Она была призвана помогать актерам делать трюки, но вышла далеко за пределы большого экрана.

Алексей Дубко, специалист по визуальным эффектам:

Дипфейк – если делать качественно, на глубоком уровне – очень сложная технология. Кроме открытого программного обеспечения надо использовать другое. Это уже коммерческий продукт. Это не технология одной кнопки. Для полуминутного видео может потребоваться от трех дней.

Техническая основа дипфейка – нейронные сети. Здесь задействован и искусственный интеллект, и анализ больших данных. Система учится тому, как может выглядеть и двигаться конкретный человек. Один из банальных примеров такого механизма – маски в Instagram.

Дмитрий Боярович, корреспондент:

Своего рода дипфейк на обывательском уровне может сделать кто угодно. Для этого достаточно смартфона и приложения, которое может изменять лицо. Например, делаем фото. Редактируем его: изменяем прическу, выражение лица, фон. Делимся в социальных сетях. И вот уже под моим аккаунтом оказывается совершенно другой человек.

Но забавные, казалось бы, возможности чреваты совсем иными последствиями: от вторжения в частную жизнь до финансовых махинаций. Первая подобного рода из-за дипфейка случилась в 2019 году. Мошенники, подделав голос главы энергетической компании, по телефону поручили перевести липовому поставщику четверть миллиарда долларов.

Кадр из х/ф «Захват», реж. Б. Чанан, 2019 г.

Причем доказать невиновность в таком случае нереально. Об этом даже сняли сериал. По сюжету полиция расследует взлом системы камер видеонаблюдения в Лондоне.

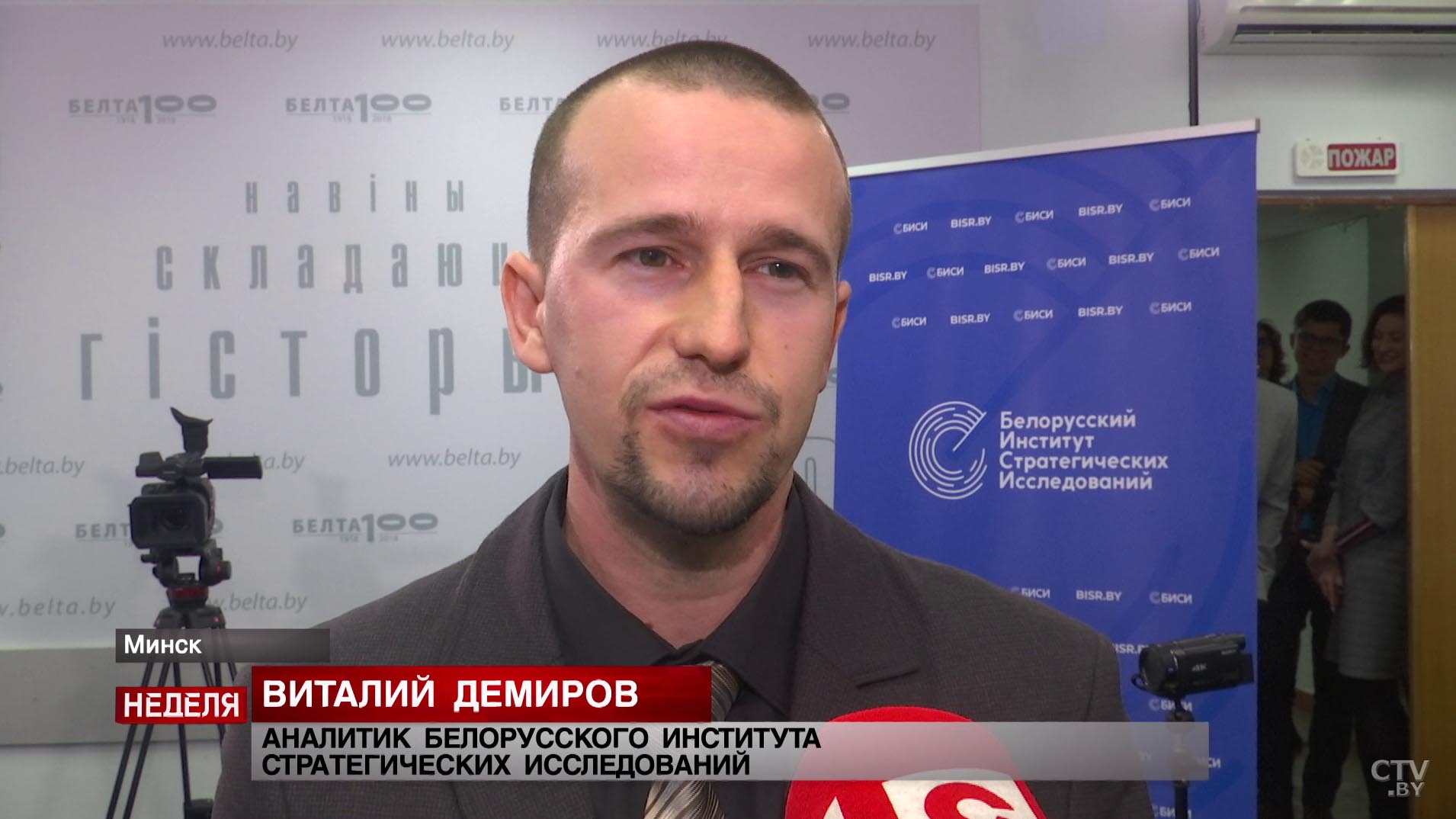

Виталий Демиров, аналитик Белорусского института стратегических исследований:

Известно, что фейки играют свою роль по воздействию на политический курс даже стабильных, устойчивых стран. Они могут вызывать панику на бирже, они могут уничтожать конкурентов. И дипфейки здесь не исключение. Это еще более мощный инструмент все тех же способов воздействия.

Сегодня в мире нет технологии, позволяющей распознавать «ненастоящие» видео. Ее лишь разрабатывают. К примеру, крупные корпорации – Facebook, Microsoft, Google – создают датасеты для обнаружения подделок. Автору лучшей «антиложь»-программы обещают 10 миллионов долларов. Между тем, дипфейк в руках злоумышленников остается мощным инструментом влияния.

Александр Ивановский, политический аналитик:

По существу, это окрашенные ценностями и стремлениями тех людей, которые их создают, попытки проверить реакцию среды на те или иные события. Есть и дополнительные эффекты: посеять неуверенность, чтобы люди захлебнулись в разночтении тех или иных событий. Ну и, конечно, все это делается для того, чтобы свою позицию показать в более выгодном свете.

В США уже признали: дипфейки представляют угрозу национальной безопасности. В мире это явление начинают регулировать. Беларусь – не исключение. В стране предлагают закрепить понятия «фейк» и «дипфейк» законодательно. Такую возможность уже рассматривают в парламенте.

Олег Гайдукевич, заместитель председателя постоянной комиссии Палаты представителей Национального собрания Беларуси:

Да, это сложно. Да, это непросто. Помните, когда стали критиковать, что мы начали говорить (и депутаты, и чиновники) о том, что надо ввести идентификацию по тем же комментариям? Это был тот шаг, который надо было сделать. Потому что анонимность и безнаказанность, когда можно оскорблять, делать что угодно и тебе за это ничего не будет – это неправильно.

Идентификация пользователей и другие поправки в закон о СМИ. Интервью с первым заместителем министра информации

Совсем недавно в России создали программу, способную синтезировать голос любого человека. Как, к примеру, звучат Владимир Познер и Ксения Собчак, вы можете услышать в видеоматериале.

Авторы идеи заявляют, что будут использовать копии голосов в рекламе, объявлениях, аудиокнигах и музейных гидах.

Но существуют риски. В плохих руках эта технология может стать оружием. Она открывает большие возможности для фальсификаций. Получается, что фактически с ней можно подделать любой разговор. Даже если речь идет о президенте страны.

Ольга Агейко:

Самое печальное, что сейчас ожидается (по прогнозам специалистов, которые занимаются этой проблематикой) – социальный интеллект будет наделен каким-то маломальским сознанием. Если это произойдет, то эти процессы могут быть вообще бесконтрольны.

Ожидается, что через полгода технология дипфейков разовьется настолько, что такие видео будет невозможно отличить от оригинальных. Объект в них может иметь не только чужое лицо, но и делать то, чего не совершал. Как бы то ни было, задуматься о вероятных последствиях этого стоит сейчас. Ведь мы уже живем в мире, где выражение «видел своими глазами» больше ни о чем не говорит.